AI 革命:一个“USB-C”接口,终结巨头垄断?

AI 进化史上的“USB-C 时刻”:MCP 协议引领去中心化之路

在人工智能的进化历程中,2024年11月 Anthropic 发布的模型上下文协议(Model Context Protocol,简称 MCP),犹如 AI 领域的 “USB-C 时刻”,正在硅谷引发一场变革。这个被誉为 “AI 界 USB-C” 的开放标准,不仅仅是重塑了大模型与物理世界的连接方式,更蕴藏着破解 AI 垄断困局、重构数字文明生产关系的密码。当我们还在争论 GPT-5 的参数规模时,MCP 已悄然铺就通向通用人工智能(AGI)时代的去中心化之路。

引言:我对 MCP 的兴奋之处

我(Bruce)最近在深入研究模型上下文协议(MCP),这是继 ChatGPT 之后,在 AI 领域第二个让我感到无比兴奋的技术。因为它有望解决我多年来思考的三个重要问题:

如何让非科学家和天才的普通人也能参与 AI 行业并从中获得收入?

AI 与 Ethereum 区块链技术之间存在怎样的双赢结合点?

如何实现 AI 的去中心化 (d/acc),避免中心化的大公司垄断和审查,最终避免 AGI 毁灭人类的潜在风险?

什么是 MCP?

MCP 是一个开放标准框架,旨在简化大型语言模型(LLM)与外部数据源和工具的集成。我们可以将 LLM 比作 Windows 操作系统,将 Cursor 等应用程序视为键盘和硬件,那么 MCP 就相当于 USB 接口,支持将各种外部数据和工具灵活地插入,供用户读取和使用。

MCP 的三种扩展能力

MCP 主要提供以下三种能力来扩展 LLM 的功能:

- Resources(知识扩展): 允许 LLM 访问外部知识库,从而获得更广泛的信息来源。

- Tools(执行函数,调用外部系统): 使 LLM 能够调用外部系统和工具,执行各种操作,例如访问 GitHub 接口。

- Prompts(预编写提示词模板): 提供预先编写好的提示词模板,帮助用户更有效地与 LLM 进行交互。

MCP 的开放性和可托管性

MCP 可以由任何人进行开发和托管,以 Server 的方式提供服务,并且可以随时下线停止服务,这保证了其开放性和灵活性。

为何需要 MCP?

目前,大型语言模型(LLM)通过使用尽可能多的数据进行大规模的运算,并将知识融入模型参数中,从而实现对话输出相应的知识。然而,这种方式存在一些比较大的问题:

胖 LLM 的局限性

这种“胖 LLM” 的模式存在诸多局限,具体表现在以下几个方面:

数据过时和算力需求

大量的训练数据和运算需要消耗大量的时间和硬件资源,而且用于训练的知识通常是过时的。

本地部署困难

大量参数的模型难以在本地设备上进行部署和使用,但实际上用户在大部分场景下可能并不需要全部信息来完成需求。

爬虫信息的质量问题

部分模型采用爬虫的方式读取外部信息以实现时效性,但是由于爬虫的限制和外部数据质量的参差不齐,可能产出误导性更强的内容。

创作者激励不足

由于 AI 并没有很好地给创作者带来利益,很多网站和内容开始实施反 AI 措施,例如生成大量垃圾信息,这将导致 LLM 的质量逐步下降。

难以扩展外部功能

LLM 很难扩展到方方面面的外部功能和操作,例如准确调用 GitHub 接口实现一些操作。它可能会按照可能过时的文档生成代码,但无法确保代码能够被精准执行。

胖 LLM 与瘦 LLM + MCP 的架构演进

我们可以将目前的超大规模模型视为胖 LLM。

胖 LLM 架构

其架构可以用下图简单表示:

用户输入信息之后,通过 Perception & Reasoning 层对输入进行拆解和推理,然后调用庞大的参数进行结果生成。

瘦 LLM + MCP 架构

基于 MCP 之后,LLM 可以聚焦在语言解析本身,剥离出去知识和能力,变成瘦 LLM:

在瘦 LLM 的架构下,Perception & Reasoning 层将关注如何将全方位的人类物理环境信息解析成为 tokens,包括但不限于:语音、语调、气味、图像、文字、重力、气温等,然后通过 MCP Coordinator 编排和协调多达数百个 MCP Servers 完成任务。瘦 LLM 的训练成本和速度将会极速提升,并且对部署设备的要求也会变得很低。

MCP 如何解决三大问题

普通人如何参与 AI 行业?

任何拥有独特才能的人都可以创建自己的 MCP Server,为 LLM 提供服务。例如,一位鸟类爱好者可以将自己多年的鸟类笔记通过 MCP 对外提供服务。当有人使用 LLM 搜索与鸟类相关的信息时,就会调用到该鸟类笔记 MCP 服务,创作者也会因此获得收入分成。

这是一种更为精准和自动化的创作者经济循环,服务内容更加标准化,调用的次数和输出的 token 都可以被精准地统计。LLM 提供商甚至可以同时调用多个鸟类笔记 MCP Servers,让用户选择和评分,从而确定谁的质量更好并获得更高的匹配权重。

AI 和 Ethereum 的双赢结合

a. 我们可以基于 Ethereum 构建一个 OpenMCP.Network 创作者激励网络。MCP Server 需要托管并提供稳定的服务,用户对 LLM 提供商付费,LLM 提供商将实际的激励通过网络分配到被调用的 MCP Servers 上,从而维持整个网络的可持续性和稳定性,激发 MCP 的创作者持续创作和提供高质量内容。这一套网络将需要使用智能合约实现激励的自动化、透明、可信和抗审查。运行过程中的签名、权限验证、隐私保护都可以使用以太坊钱包、ZK 等技术实现。

b. 开发 Ethereum 链上操作相关的 MCP Servers,例如 AA 钱包调用服务,用户将可以在 LLM 里面通过语言实现钱包付款,而无需暴露相关的私钥和权限给 LLM。

c. 还有各种开发者工具,进一步简化 Ethereum 智能合约开发和代码生成。

实现 AI 去中心化

a. MCP Servers 将 AI 的知识和能力去中心化,任何人都可以创建和托管 MCP Servers,注册到例如 OpenMCP.Network 这样的平台上面之后,按照调用获得激励。没有任何一家公司可以掌握全部的 MCP Servers。如果一个 LLM 提供商给予 MCP Servers 不公平的激励,创作者将可以屏蔽该公司。用户如果得不到优质结果,将会更换其他 LLM 提供商,从而实现更公平的竞争。

b. 创作者可以对自己的 MCP Servers 实现细粒度的权限控制,以保护隐私和版权。瘦 LLM 提供商应该通过提供合理的激励来让创作者贡献高质量的 MCP Servers。

c. 瘦 LLM 的能力差距将会慢慢抹平,因为人类的语言是有遍历上限的,演进也很缓慢。LLM 提供商将需要把目光和资金瞄向高质量的 MCP Servers,而不是重复使用更多显卡“炼丹”。

d. AGI 的能力将得到分散和降权,LLM 仅作为语言处理和用户交互的接口,具体能力分布在各个 MCP Servers 里面。AGI 将不会威胁到人类,因为关闭 MCP Servers 之后,它就只能进行基础的语言对话。

总体回顾

LLM + MCP Servers 的架构演进,本质上是将 AI 能力去中心化,降低了 AGI 毁灭人类的风险。

LLM 的使用方式,使其对 MCP Servers 的调用次数和输入输出可以做到 token 级别的统计和自动化,为 AI 创作者经济系统的搭建奠定了基础。

好的经济系统可以驱动创作者主动贡献创作高质量的 MCP Servers,从而带动整个人类的发展,实现正向飞轮。创作者不再抵御 AI,AI 也会提供更多岗位和收入,将类似 OpenAI 这样的垄断商业公司的利润合理分配。

这一套经济系统,结合其特性和创作者的需求,非常适合基于 Ethereum 实现。

未来展望:下一步的剧本演进

MCP 或者类 MCP 的协议将会层出不穷,几家大公司将开始竞争标准的定义。

MCP Based LLM 将会出现,专注于解析和处理人类语言的小模型,附带 MCP Coordinator 接入 MCP 网络。LLM 将支持自动发现和调度 MCP Servers,无需复杂的手工配置。

MCP Network 服务提供商将出现,每家有自己的经济激励系统,MCP 创作者将自己的 Server 注册和托管即可得到收入。

如果 MCP Network 的经济激励系统使用 Ethereum 构建,基于智能合约,那么 Ethereum 网络的 transactions 保守估计将增加约 150 倍(按照非常保守的每天 1 亿次 MCP Servers 的调用量,目前 12s 一个 Block 包括 100 txs 计算)。

股票型基金

MORE>-

揭秘中国股市的“缅A”:国家队、规则与散户的博弈

近年来,不少人谈论着“缅A”,却对这个概念知之甚少。实际上,它指的是...

-

黄金期货趋势预测:技术、基本面与市场情绪的综合分析

黄金期货市场波动剧烈,精准预测其走势是众多投资者追求的目标。然而,黄...

-

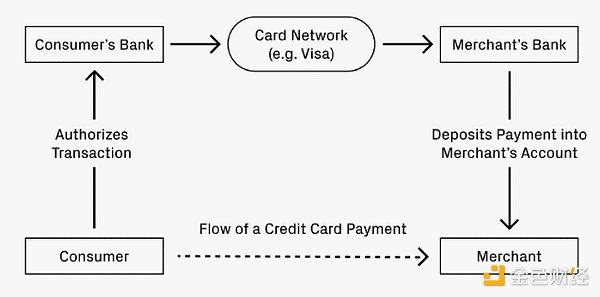

稳定币的未来:借鉴信用卡网络的成功经验

稳定币是近年来最具变革性的支付方式,改变了资金流动的模式,其低廉的跨...

-

ETH 4小时K线图技术分析:短期震荡,谨慎观望

近期ETH价格经历震荡下跌,当前价格在2446.38美元附近运行。4...

-

基金圈大地震!贝莱德、红塔红土同时换帅,背后真相细思极恐!

基金公司高管变动频繁:贝莱德与红塔红土双双换帅近期,基金行业人事...

-

感谢分享石四药集团的公告解读!这篇文章分析得比较全面,结合了资本运作、公司发...

-

感谢分享博时中债5-10农发行A基金的信息!近一年11.23%的收益率看着不...

-

感谢分享ChatGPT的分析,很有参考价值。文中提到的‘拉高出货’和鲸鱼操纵...

-

似水年华 评论文章:金属价格下跌,原因复杂,宏观经济和供需关系是主要因素。区块链技术应用于金属市...

-

跌破10万美元?这波动也太大了!看来特朗普的政策影响比想象中复杂,专家预测更...

- 最近发表

-

- 2025医药基金异军突起:蔡依林、易烊千玺都看好,创新药策略领跑,港股科创板成关键血謎拼圖

- 股市“虚假繁荣”藏隐忧:大盘股护盘难掩空头逆袭,成交量不足需警惕

- 孟耿如关注!美股震荡、孙兴慜赛事:掌握交易真谛,迎接挑战

- 美股震盪避險情緒升,地緣政治推升黃金看漲,國泰金籲配置抗系統風險。

- 金價震盪機遇:懸壺金翁策略、美債殖利率影響與NBA MVP啟示

- 宠物经济万亿商机:源飞宠物营收藏隐忧,蔡力行也关注,威力彩般诱人?

- 有友食品西雅展:鳳爪創新升級,打造國民零食品牌

- 烘焙奧運:中國國際焙烤展揭幕,聖牧塞茵蘇「0芽孢」馬斯卡彭引領清潔標籤革命

- 深交所全球投資者大會:聚焦中國新質生產力,警惕投資風險與挑戰

- 2029加密貨幣:比特幣島興衰、中本聰神話與隱秘圈的覺醒【蘇花公路、fantasy life i】